隨著數位化浪潮席捲全球,數據中心已成為現代科技運作的命脈。雲端運算、人工智慧(AI)、區塊鏈和大數據處理需求的激增,使得數據中心的規模與複雜性不斷提升。然而,這也帶來了顯著的挑戰——能源消耗與冷卻效率。根據國際能源署(IEA)的數據,全球數據中心的電力消耗占總用電量的1%至3%,其中冷卻系統的能耗往往占據總能耗的40%至50%。因此,如何優化冷卻系統不僅關乎運營成本的降低,還直接影響設備的可靠性與環境的可持續性。

本篇文章旨在為初學者與專業人士提供一份全面的入門指南,聚焦於數據中心冷卻的兩個核心主題:氣流管理(Airflow Management, AFM)的最佳實踐和冷卻優化策略。我們將從科學原理出發,逐步深入探討氣流管理的關鍵概念、具體實施方法,以及冷卻優化的步驟與效益。無論您是數據中心的管理者、工程師,或僅對此領域感興趣,本文都將以清晰的結構和實用的建議,幫助您掌握數據中心冷卻的基礎知識並應用於實務中。

氣流管理的基本原理

什麼是氣流管理?

氣流管理是指在數據中心內控制空氣流動的過程,目的是確保冷空氣有效到達 IT 設備,同時將熱空氣順利排出,避免冷熱空氣混合。這種管理對於提升冷卻效率至關重要,因為任何氣流的浪費或無序流動都可能導致能耗增加或設備過熱。

在典型的數據中心設計中,冷卻空氣通常由冷卻設備(如精密空調或 CRAC 單元)產生,通過高架地板下的靜壓箱輸送至機房,經穿孔磚進入冷通道,供 IT 設備使用。設備吸收熱量後,熱空氣從機架後方排出,進入熱通道,最終通過回風系統返回冷卻設備。這一循環若受到干擾,例如冷空氣未到達目標或熱空氣回流,就會降低冷卻效率。

氣流管理的重要性

氣流管理的價值在於其對數據中心運營的多重影響。以下是其關鍵優勢:

- 降低 IT 設備進氣溫度

通過分離冷熱空氣,IT 設備能獲得穩定的低溫冷卻,減少熱點(Hot Spots)的風險。熱點可能導致設備過熱,進而影響性能或引發故障。 - 提升冷卻系統效率

當熱空氣直接返回冷卻設備,回風溫度升高,這能讓冷卻系統在更高效率下運行。例如,較高的回風溫度有利於蒸發器的工作效率,減少壓縮機的負擔。 - 減少能源浪費

氣流管理能減少旁路氣流和再循環現象,將冷卻資源集中在 IT 設備上,從而降低不必要的能耗。 - 改善電源使用效率(PUE)

PUE(Power Usage Effectiveness)是數據中心能源效率的關鍵指標,計算公式為總能耗除以 IT 設備能耗。理想 PUE 接近 1.0,而優化氣流管理是實現低 PUE 的基礎。 - 增強設備壽命與可靠性

穩定的冷卻環境能減少設備因過熱而損壞的風險,延長硬件壽命,降低維護成本。

氣流管理的科學原理

旁路氣流(Bypass Airflow)

旁路氣流是指冷卻設備輸出的冷空氣未經過 IT 設備就直接返回冷卻設備的情況。這種現象浪費了冷卻資源,因為冷空氣未被充分利用。

計算方法

旁路氣流的數量可以用以下公式估算:

旁路氣流(CFM)= 冷卻設備總氣流量(CFM)- IT 設備總氣流量需求(CFM)

例如,若冷卻設備提供 12,000 CFM(立方英尺每分鐘)的冷空氣,而 IT 設備僅需要 9,000 CFM,則有 3,000 CFM 的旁路氣流。

影響

- 降低冷卻效率,因為部分冷空氣未參與熱交換。

- 增加冷卻設備的運行負擔,可能導致風扇過載。

解決方法

- 密封漏洞:檢查並密封高架地板上的電纜開口、未使用的穿孔磚或其他氣流泄漏點。

- 調整風量:使用變頻驅動(VFD)技術,根據 IT 設備的實際需求動態調整冷卻設備的風扇速度。

- 冷通道封閉:在冷通道安裝頂板和門,確保冷空氣僅流向機架前方。

再循環(Recirculation)

再循環是指 IT 設備排出的熱空氣未經冷卻設備處理就再次進入設備進氣口,導致進氣溫度升高。

影響

- 設備過熱:進氣溫度升高可能超出設備的設計範圍,影響性能。

- 冷卻負擔增加:冷卻設備需產生更多冷空氣以抵消熱空氣的影響,增加能耗。

解決方法

- 熱通道封閉:在熱通道安裝封閉系統,確保熱空氣直接返回冷卻設備。

- 機架盲板:在機架未使用的空間安裝盲板,防止熱空氣從後方回流至前方。

- 優化佈局:調整機架排列,確保冷熱通道分離清晰。

溫差(Delta T)的重要性

溫差(Delta T)是診斷數據中心冷卻系統健康狀況的核心指標。通過監測四個關鍵溫差,我們可以快速識別氣流管理的問題並進行優化。

四個溫差

- 冷卻設備溫差

- 定義:冷卻設備回風溫度與供應溫度之差。

- 理想值:通常為 10-20°C,視設備設計而定。

- 意義:反映冷卻系統的熱交換效率。

- IT 設備溫差

- 定義:IT 設備排氣溫度與進氣溫度之差。

- 理想值:一般為 15-25°C,依設備規格而異。

- 意義:顯示設備的熱負載和冷卻需求。

- 冷卻供應至設備進氣溫差

- 定義:冷卻設備供應溫度與 IT 設備最熱進氣溫度之差。

- 理想值:接近 0°C,表示無再循環。

- 意義:若溫差過大,可能是熱空氣回流導致。

- 設備排氣至冷卻回風溫差

- 定義:IT 設備排氣溫度與冷卻設備回風溫度之差。

- 理想值:接近 0°C,表示無旁路氣流。

- 意義:溫差大可能意味著熱空氣未有效返回。

監測與調整

- 工具:使用溫度感測器和環境監控系統(如 DCIM)記錄各點溫度。

- 步驟:

- 定期收集數據,建立溫差基準。

- 若發現異常(如冷卻供應至設備進氣溫差過大),檢查是否存在再循環。

- 根據診斷結果,實施氣流管理措施(如安裝盲板或調整穿孔磚)。

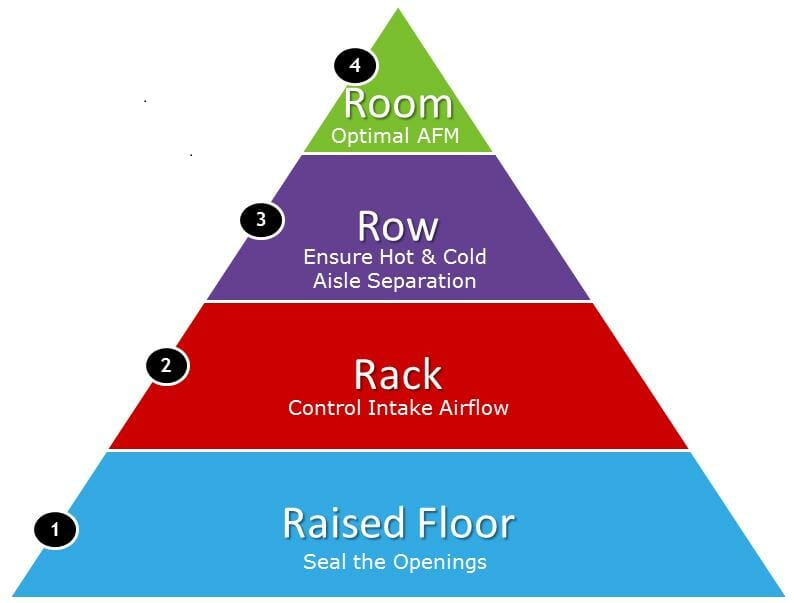

氣流管理的 4R 最佳實踐

為了系統化地優化氣流管理,業界提出了「4R」框架:機架(Rack)、高架地板(Raised Floor)、行(Row)和房間(Room)。以下是每個層面的詳細實踐指南。

Raised Floor – 高架地板氣流管理

目標:確保冷空氣從高架地板有效輸送至冷通道。

實踐方法:

- 密封開口:使用刷條或泡沫密封電纜穿孔,防止冷空氣泄漏。

- 穿孔磚佈局:僅在冷通道下方安裝穿孔磚,避免冷空氣流入熱通道。

- 靜壓管理:維持高架地板下 20-50 Pa 的靜壓,確保氣流均勻。

- 定期檢查:修復地板破損,保持氣密性。

常見問題與解決方案:

- 問題:冷通道氣流不足。

- 解決方案:增加穿孔磚開口率或提升冷卻設備風量。

Rack – 機架氣流管理

目標:確保機架內每一台 IT 設備獲得充足冷卻。

實踐方法:

- 安裝盲板:在機架未使用的空間安裝盲板,防止冷空氣從前方逸出或熱空氣回流。

- 統一氣流方向:設備應面向冷通道進氣,後方排氣,避免氣流衝突。

- 檢查機架門:確保機架門的穿孔率足夠(通常 >70%),不阻礙冷空氣進入。

- 機架封閉:使用頂部封板或側板,進一步隔離冷熱氣流。

常見問題與解決方案:

- 問題:機架頂部設備過熱。

- 解決方案:安裝氣流導向器,引導冷空氣向上流動。

Row – 行氣流管理

目標:通過機架排列優化冷熱通道效能。

實踐方法:

- 冷熱通道設計:機架正面朝冷通道,背面朝熱通道,形成交替佈局。

- 通道封閉:在冷通道或熱通道安裝頂板和門,隔離氣流。

- 通道寬度:冷通道寬度建議為 1.2-1.5 米,確保氣流集中。

- 氣流引導:在通道末端安裝導向器,改善氣流分佈。

常見問題與解決方案:

- 問題:熱通道空氣滯留。

- 解決方案:增加熱通道排風設備或調整回風路徑。

Room – 房間氣流管理

目標:優化整個機房的氣流模式。

實踐方法:

- 冷卻設備位置:將冷卻設備放置在靠近冷通道的區域,減少氣流損失。

- 回風設計:利用天花板作為回風通道,提升熱空氣收集效率。

- CFD 模擬:使用計算流體力學(CFD)分析機房氣流,識別死角。

- 整體監控:部署氣流感測器,實時掌握機房環境。

常見問題與解決方案:

- 問題:機房角落出現熱點。

- 解決方案:安裝輔助風扇或調整冷卻設備角度。

冷卻優化的具體過程

優化目標

冷卻優化的目標是以最低的冷卻空氣流量和最高的供應溫度,提供適當的 IT 設備進氣條件和冷卻冗餘,從而在保證設備安全的同時提升能源效率。

實施步驟

- 奠定氣流管理基礎

通過 4R 實踐,確保冷熱氣流有效分離。 - 監測溫差

定期記錄四個溫差,診斷系統問題。 - 調整冷卻參數

- 逐步提高供應溫度(如從 18°C 升至 25°C)。

- 降低風扇速度,減少電力消耗。

- 確保 IT 設備進氣溫度在 ASHRAE 建議範圍(18-27°C)內。

- 引入高效技術

- 變頻驅動(VFD):動態調整風扇和泵的轉速。

- 自然冷卻(Free Cooling):利用外部低溫空氣或水源。

- 熱回收:將廢熱用於供暖或其他用途。

- 持續優化

IT 負載隨時間變化,需定期審查並調整策略。

案例研究

案例一:企業數據中心改造

背景:某企業數據中心 PUE 高達 2.1,冷卻能耗過高。

措施:

- 機架安裝盲板,密封高架地板漏洞。

- 實施冷通道封閉,提升氣流效率。

- 提高供應溫度至 24°C,降低風扇速度 15%。

結果:

- PUE 降至 1.6,節能 25%。

- 設備穩定性提升,故障率降低 10%。

案例二:雲端服務商升級

背景:某雲服務商追求綠色數據中心認證。

措施:

- 全面採用 4R 實踐。

- 引入 VFD 和自然冷卻技術。

- 優化回風路徑,提升熱空氣收集效率。

結果:

- PUE 降至 1.3,年節電 150 萬度。

- 碳排放減少 18%,獲得環保認證。

新興技術與趨勢

隨著數據中心技術的快速發展,新興冷卻技術和趨勢不斷湧現,以滿足日益增長的運算需求和能源效率要求。以下是幾個值得關注的重點領域,為數據中心的未來發展指明方向:

液冷技術的崛起

傳統空氣冷卻在高密度運算環境中逐漸顯得力不從心,尤其是在人工智慧(AI)、機器學習和高性能運算(HPC)等領域,設備散熱需求激增。液冷技術憑藉其高效的熱傳導能力脫穎而出。

- 直接液冷(DLC):通過將冷卻液輸送到設備內部,直接與發熱元件(如 CPU 或 GPU)接觸,能快速移除熱量。

- 浸沒式冷卻(Immersion Cooling):將整個伺服器浸入非導電冷卻液中,利用液體的高熱容實現全面冷卻。研究表明,液冷的熱傳導效率比空氣高出數百倍,可大幅降低能耗並提升冷卻效能。

補充:可參閱

Liquid Cooling – 聽聽HPE談數據中心液冷的未來

Immersion Cooling – 浸沒式液冷是數據中心散熱的終極解決方案

模塊化數據中心的普及

模塊化設計以標準化、預製的結構為數據中心提供靈活性和擴展性。這種方法不僅縮短建設時間,還能根據運算需求快速調整冷卻配置。例如,模塊化數據中心常採用冷熱通道封閉和精確氣流管理技術,從而優化冷卻效率並減少能源浪費。

AI 與機器學習的應用

人工智慧(AI)和機器學習(ML)正在改變數據中心冷卻的管理方式,提供智能化解決方案。

- 預測性維護:AI 分析歷史數據和即時監測,預測冷卻設備的潛在故障,提前採取維護措施以避免停機。

- 動態調節:根據運算負載和外部氣候條件,AI 自動調整風扇速度、冷卻液流量或溫度設定,實現能源效率最大化。

- 氣流模擬優化:結合計算流體力學(CFD),AI 可模擬機房氣流分佈,發現熱點並提出改善建議。

熱回收技術的潛力

數據中心產生的廢熱不再只是負擔,而是可轉化為資源的機會。熱回收系統能將廢熱用於區域供暖、溫室加熱甚至發電。例如,北歐的數據中心已成功將廢熱接入城市供熱網,實現能源循環利用,同時降低碳排放。

綠色能源的深度整合

為實現碳中和目標,數據中心正積極採用太陽能、風能和水力發電等可再生能源。此外,先進的儲能系統(如鋰電池或氫能儲存)能穩定能源供應,確保在可再生能源間歇性波動時,冷卻系統仍能穩定運行。

行業標準與規範

數據中心的設計與運營受到多項國際標準和規範的約束,這些規範確保其安全性、可靠性和效率。以下是幾個核心標準的詳述,為行業提供明確指導:

ASHRAE 環境條件指南

美國供暖、製冷與空調工程師學會(ASHRAE)制定的標準被廣泛應用於數據中心冷卻設計。

- 建議運行範圍:IT 設備進氣溫度 18-27°C,相對濕度 20%-80%,確保設備穩定運行。

- 擴展允許範圍:針對更高耐熱性的設備(如 A3 或 A4 等級),進氣溫度可提升至 40°C 或更高,鼓勵更靈活的冷卻策略。

ASHRAE 還提供熱負載管理和冷卻系統設計的最佳實踐。

Uptime Institute 分級標準

Uptime Institute 將數據中心分為 Tier I 至 Tier IV 四個等級,評估其基礎設施的可靠性和冗餘性。例如,Tier IV 級數據中心要求完全冗餘的冷卻系統,確保即使部分系統故障也能維持運作。該機構的認證也涵蓋能源效率和運營管理。

補充:可參閱

UPTIME TIER RATINGS – 數據中心4個層級

ISO/IEC 30134 效率指標

這套國際標準定義了數據中心的關鍵績效指標(KPI):

- PUE(電力使用效率):衡量總能耗與 IT 設備能耗的比率,業界目標通常低於 1.5。

- WUE(水使用效率):評估冷卻系統的用水量,推動水資源節約。

- CUE(碳使用效率):量化碳排放,為可持續性提供依據。

補充:可參閱

PUE (Power Usage Effectiveness)簡介

WUE(Water Usage Effectiveness)簡介

CUE (Carbon Usage Effectiveness)簡介

Green Grid 的貢獻

Green Grid 是一個專注於數據中心效率的全球組織,其提出的 PUE 指標已成為業界標準。此外,它還發布了冷卻系統設計和資源管理的指南,幫助企業優化運營。

LEED 環保認證

能源與環境設計先鋒獎(LEED)評估建築的可持續性,數據中心若採用節能冷卻技術和綠色建材,可獲得該認證,提升企業的社會責任形象和市場競爭力。

這些標準共同構建了數據中心的規範框架,確保其在高效運行的同時,滿足安全和環保要求。

環境與可持續性

數據中心的能源消耗和環境影響備受關注,冷卻系統的優化成為實現可持續發展的關鍵。以下是相關內容的補充:

節能減排效益

通過精確的氣流管理和高效冷卻技術,數據中心可顯著降低能耗。例如,採用冷熱通道隔離和變頻風扇能將 PUE 降至 1.2 以下,減少電力需求並降低溫室氣體排放。

延長設備壽命

穩定的冷卻環境能防止 IT 設備因過熱而損壞,延長其使用壽命。這不僅降低了更換成本,還減少了電子垃圾,對環境保護具有積極意義。

綠色能源的應用

高效冷卻系統與可再生能源的整合是實現零碳運營的趨勢。例如,利用太陽能驅動冷卻設備,或將風能用於機房通風,能大幅降低化石燃料依賴。

水資源的可持續管理

在使用液冷或蒸發冷卻的數據中心中,水資源管理至關重要。閉環冷卻系統和廢水回收技術能減少水耗,符合節水原則。例如,某些先進數據中心已實現每年水耗減少數十萬加侖的目標。

企業社會責任的體現

隨著公眾對環境問題的關注增加,數據中心通過提升可持續性表現,不僅能滿足監管要求,還能增強品牌吸引力,贏得客戶和投資者的青睞。

結論

數據中心冷卻技術是確保其高效、可靠運行的基石,而氣流管理和冷卻優化則是其中的核心環節。從基礎的機架盲板安裝到先進的 AI 動態調節,再到液冷技術和熱回收系統的應用,這些技術共同推動數據中心向更高效率和可持續性邁進。

冷卻優化的過程需要持續的監測與改進,正如專家所言,「效率不是一勞永逸的結果,而是需要管理的目標」。通過遵循行業標準、採用新興技術並承擔環境責任,數據中心能在經濟效益與生態效益間找到平衡。

展望未來,隨著液冷技術的成熟、AI 的深入應用以及綠色能源的普及,數據中心冷卻領域將迎來更多創新機遇。這不僅是技術進步的體現,也是對可持續發展承諾的實踐。希望這些內容能為您提供全面的洞察,助力您在數據中心領域的探索與實踐。